広告について。

サイト運営のため、Googleアドセンス

による広告があります。

Contents - 目次

Soraの仕組みと一般公開されたデモ動画。

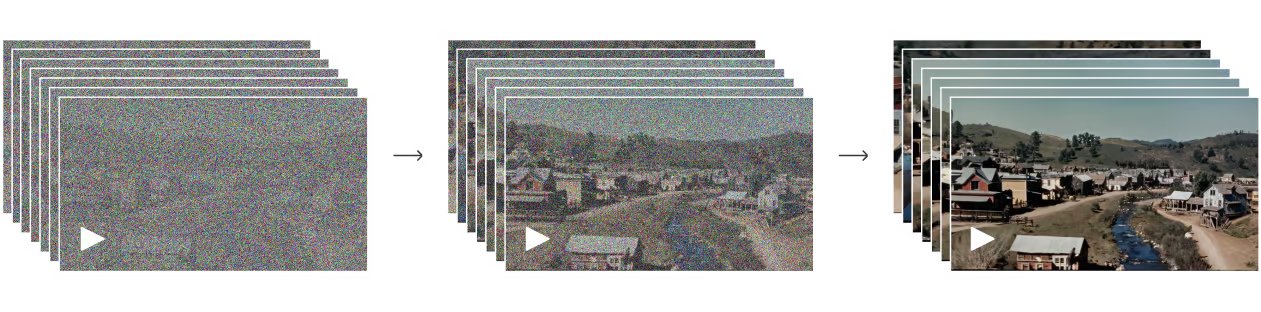

Soraのデモ動画:ゴールドラッシュ – Gold Rush

空撮されたような、カリフォルニアのゴールドラッシュ。

19世紀のカリフォルニアの街、川を中心に木造建築物と馬に乗った人々が住む街を、空からドローンで撮影したように生成された動画。

画質はあえて古いカラー映画のようにしたようで、ぱっと見、実写の映画と見分けがつかない。

つまり、実写の映像から学習している可能性が想定される。

Soraの仕組みと解説。

画像データと動画データ。

画像データとは?

画像の仕組みはピクセルの集合体。

基本的にピクセルの位置はX軸とY軸、奥行きのある3Dの場合はZ軸で指定でき、色はRGB(赤・緑・青)の混ぜ合わせで表現できる。

(※印刷の場合はドットの集合体。色はCMYK(シアン・マゼンタ・イエロー・ブラック)の混色で表現される。)

動画データとは?

動画の仕組みは連続画像の集合体。

基本的に「パラパラマンガ」のイメージで、1秒間の画像枚数を「FPS(Frame per Second)」という単位で決められる。

例えば一般的な日本のテレビの場合は「30fps」、一般的な映画の場合は「24fps」となっている。

つまり、テレビは1秒間に30枚の画像、映画は1秒間に24枚の画像が使われている。

Soraの動画の時間と画像の枚数。

Soraは最大60秒の動画を生成できるので、1秒間の枚数(フレームレート)を30fpsとした場合、30 × 60 = 1,800枚となる。

マンガがアニメ化されるときに漫画家自身が描かないのは、現実的にひとりでは描けない量を必要とするという側面もある。

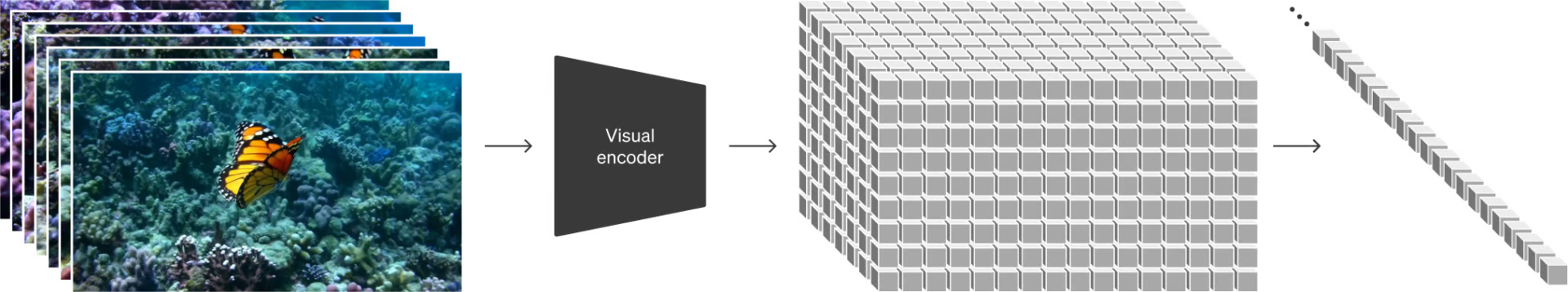

画像データとパッチ化。

ビジュアルデータをパッチ化

– Turning visual data into patches

Soraは、ビジュアルデータをパッチ化しているとのこと。

引用元:https://openai.com/research/video-generation-models-as-world-simulators

パケットやトークンのような感じで。

通信量パケ放題の「パケット」や、ChatGPTの「トークン」のように、画像のデータを一旦まとめて(パッチ化して)、単位のように扱っている模様。

トークンとは?

ChatGPTやGemini、CopilotなどのLLM(大規模言語モデル。大量のテキストデータとディープラーニングで学習したAI。)にはトークンというものがある。

テキストのトークンとは、文章の一部を塊として認識するような、単語や文字列の最小単位のようなもの。

ニューロンとシナプスと、トランスフォーマー。

動画生成用のスケーリング トランスフォーマー

– Scaling transformers for video generation

Soraによるゴールドラッシュの動画は、OpenAIのサイトでざっくりと仕組みが解説されている。

ChatGPTやGoogleのGeminiのベースとなっているニューラルネットワークの、「Transformer(トランスフォーマー)」が使われているという。

ニューラルネットワークとは?

ニューラルネットワークは、人間の脳の神経網を模倣した技術。

仕組みとしては、人間の脳のニューロン(脳を構成する神経細胞)同士を、シナプスがつなぎ合わせていくようなイメージ。

例えば、今その場にいない友人知人の顔や、以前にどこかで見た景色を、徐々に思い出していく感覚が近いかもしれない。

引用元:https://openai.com/research/video-generation-models-as-world-simulators

Transformerとは?

Googleの研究者たちが開発したディープラーニングのモデル。ChatGPTの最後の「T」はTransformerの「T」。

(GPT:Generative Pre-trained Transformers)

AI半導体大手のNVIDIAのブログには、以下の記載がある。

Transformer モデルは、この文章に含まれる単語のように、連続したデータの関係を追跡することによって、文脈ひいては意味を学習するニューラルネットワークです。

並列処理が可能。

しかも、Transformer が使用する計算は並列処理に適しているため、モデルの高速実行が可能です。

引用元:Transformer モデルとは? | NVIDIA

検索エンジンでも。

また、Transformerは、GoogleやBingで検索するときにも使われているとのこと。

つまり何かを探すときにキーワードを入力し、検索を始めた瞬間、中の方でTransformerが動き出す。

そして段々とノイズが除かれ、クリアになり、目的のサイトへたどり着く。

という、ニューラルネットワークがつながる感じとなる。

Soraのトレーニングと学習サンプル。

サンプルが少ないものは難しいのかも。

記憶 – 思い出しやすい記憶と思い出しにくい記憶。

人間がすぐにピンとこないものを思い出しにくいように、Soraも完璧ではない。

あらかじめ学習していないもの、トレーニングをしていないものを生成するのは難しいと思われる。

前述のゴールドラッシュの動画の場合は、写真やハイウッド映画やドローン映像などがあるため、人間でも頭の中でなんとなくイメージすることができる。

空飛ぶアヒルとドラゴンのハーフ。

アヒルとドラゴンのハーフは実在しないので、人の頭の中でもすぐに想像するのが難しい。

Soraの公開後、X(旧Twitter)上でOpenAIのサム・アルトマン(Sam Altman)CEOが動画のキャプションをリクエストし、OctaneAIのマット・シュリヒト(Matt Schlicht)CEOがテキストを送った。

その送られたキャプションで作成した動画は、最初は期待通りではなかった。

「空飛ぶアヒルとドラゴンのハーフ」は実在せず、有名なキャラクターもいない。

なので人間の頭でもイメージがつきにくく、世にも出ていない。つまり学習サンプルの数が限られている。

それでも、良い感じの(betterな)ものもあるよ、というのがSoraのポテンシャル。

https://t.co/WJQCMEH9QG pic.twitter.com/Qa51e18Vph

— Sam Altman (@sama) February 15, 2024

here is a better one: https://t.co/WJQCMEH9QG pic.twitter.com/oymtmHVmZN

— Sam Altman (@sama) February 15, 2024

Soraにトレーニングされては困る場合。

仕事やプライベートがなくなっては困る。

生成AIへの期待と不安。

生成AIへの期待が高まる一方、自分が撮った写真や映像を、AIに学習させたくないという場合もある。

特にお仕事として、生計を立てている場合は、そう簡単にAIに生成されては困る。

著作権侵害となる可能性も生じる。

また、何気なくアップしたプライベートな画像や映像もそうだろう。

自分を守るための、学習させないという選択肢。

そのような場合は、クロールを拒否できる設定があると、人間にとってはありがたい。

ChatGPTの場合は、すでにクロールをさせないコードが公表されている。

参考:ChatGPTのアクセスを制限。GPTBotにクロールさせない方法。

OpenAI社のデザイン力。

OpenAIは、ChatGPTなどのツールにも、サイトのデザインにも、高いセンスが感じられる。

神は細部に宿るという言葉があるように、それらからは、無責任さを感じない。

なので、安易にSoraをリリースせずに、人間社会の空気感やルールが整備されるまで、段階を踏んでいるのかもしれない。

以上、参考になれば幸いです。

※Webデザインは実務数年、職業訓練校講師数年、フリーランス数年、計15年以上のキャリアがありますが、一気にがぁっと書いているので「です・ます調」ではありません。(元々はメモ書きでした。) ※事実や経験、調査や検証を基にしていますが、万一なにかしら不備・不足などがありましたらすみません。お知らせいただければ訂正いたします。 ※写真は主にUnsplashやPixabayのフリー素材を利用させていただいております。その他の写真や動画もフリー素材やパブリックドメイン、もしくは自前のものを使用しております。

AI 関連メモ。

ChatGPT 関連メモ。

- Gemini 3。アプリや検索、Google AI Studioで無料でも使える最新モデル。

- ChatGPTの性格設定。パーソナライズで会話をしやすいように。

- ChatGPT(チャットGPT)を4oに戻したいとき。無料でもGPT-4o風に。

- ChatGPT最新「GPT-5」の性能。有料ユーザーから無料ユーザーへ。

- ChatGPTだけで被写体背景の切り抜き、背景色を変更する方法。

- ChatGPT 4o Image Generationの使い方の例。画像生成ができないとき。

- ChatGPTの最新推論モデル「o3-mini」の使い方とヒント。

- ChatGPTの次世代モデル、GPT-4.5とGPT-5のリリース時期と可能性。

- ChatGPTの最新推論モデル「o3-mini」の使い方とヒント。

- ChatGPT searchとは?使い方や、有料と無料、Googleとの違い。

- Chrome拡張機能、ChatGPT searchの使い方。自然言語、日常会話で検索。

- ChatGPTに検索機能。ChatGPT searchでWeb検索が可能に。

- MacとWindowsでもChatGPTと音声会話。Advanced Voiceが利用可能に。

- Advanced Voiceによる音声会話。ChatGPTとプラトニックな関係に?

- OpenAI o1の使い方。考えてから答える新しいChatGPTモデル。

- Voice Engineという名の、音声合成技術。日本語の精度は?

- SearchGPT。ChatGPTがAI検索エンジンに。使い方の例と順番待ちへの登録方法。

- GPT-4o miniが登場。ChatGPT無料版はGPT-3.5からバージョンアップ。

- ChatGPT無料ユーザーにもメモリ機能が。記憶や使い方の例。

- iPhoneやiPad、MacでChatGPT(GPT-4o)が。Apple Intelligence。

- 生成AIとWebデザイン、ChatGPTを活用したコーディングに必要なもの。

- ChatGPT最新モデル GPT-4oが無料でも。使える主な機能。

- ChatGPT(GPT-4o)で、PDF要約の精度を検証した結果。

- GPT-4o。ChatGPTと画像見ながら音声で会話?有料でも無料でも。

- ChatGPT無料版でも画像生成が可能に。有料版だけじゃない!?

- ChatGPT(チャットGPT)にアーカイブ機能が。復元も削除も。

- ChatGPT(チャットGPT)を日本語化。日本語設定の方法。

- ChatGPT(チャットGPT)との音声会話と、音声の変更方法。

- ChatGPTアプリのインストールとログイン方法、チャットの使い方。

- ChatGPT(チャットGPT)のスペルチェック、文章校正がむっちゃ楽。

- ChatGPT(チャットGPT)へのログイン方法。ログインできないとき。

- ChatGPTにプラグイン。広がる機能と使い方。最新情報へも。

- ChatGPTがLINEに?「AIチャットくん」の始め方、そして使い方。

- ChatGPTの始め方と使い方と。初心者向けシンプル版。

- ChatGPTはSVGアイコンを作れるのか?

- ChatGPTの文章作成やコーディング、SEO対策は変わるか?

Gemini 関連メモ。

- Geminiで画像の作成や編集。人物や写真、イラストの商用利用と注意点。

- Gemini 2.5 Proがアップグレード。Google AI Studio無料プランの使い方。

- Deep Researchというリサーチツール?無料で使えるGoogle Gemini。

- GeminiアプリがiOSにも。Googleアプリからはアクセス不可に。

- ChatGPTやGeminiなど生成AIの年齢制限と、AI使用のリスク。

- NotebookLMは使えない?YouTube動画とPDFの使い方と検証結果。

- Google AI Studioの「Gemini 1.5 Pro 002とGemini Experimental 1114」にできること。

- ChromeがGoogle レンズで検索、アドレスバーからGeminiの利用が可能に。

- Gemini 1.5 Pro 2Mモデル。Waitlistの登録手順。日本語上手なGoogle生成AI。

- BardからGeminiに。使い方はどう変わる?日本語対応は?

- Gemini(旧Bard)が絵を描けるように。テキストから画像生成の方法。

- Gemini(旧Bard)の画像認識の使い方。日本語対応済み、Googleレンズで画像読み取り。

- 最新情報を日本語かつ無料で使いたいときは、GoogleのBard?

- ChatGPTとBardの違い。なぜAIは日本語チャットが苦手なの?

- Bard(Gemini)が日本語対応。ログイン方法や最新情報など、使い方の例。

- BardでGemini。Googleの最新AIを無料で使う方法。

- GoogleのBardは、OpenAIのChatGPTを越えられるだろうか?

Copilot、Bing 関連メモ。

- ChatGPTとCopilotの違い。料金や、できることと、できないこと。

- Copilotとは? GPT-4とDALL·E 3が無料で使える生成AI。

- SkypeのBingチャット。GPT-4を日本語かつ無料で使える。& 注意点。

- BingのGPT-4、チャットの使い方。使えない?(今はまだ。)

- MacでGPT-4(ChatGPT最新版)を使う場合、Edgeが必要なのかも。

Llama 関連メモ。

- Llama 3.1登場。MetaのオープンソースAIとダウンロードサイト。

- Meta Horizon OSとApple Vision Pro。オープンかクローズか。

- Llama 3。無料でオープンソースなMeta AI最新モデル。

- Llama(ラマ)の使い方や日本語は? ダウンロード手順とブラウザ実装サイト。